BOOK SEARCH

しくみがわかる深層学習

手塚 太郎(著)

ネット書店で購入する amazon e-hon 紀伊國屋書店 丸善ジュンク堂書店 Honya Club Rakutenブックス くまざわ書店

書店の店頭在庫を確認する 紀伊國屋書店

内容紹介

深層学習(ディープラーニング)の仕組みを,ベクトル,微分などの基礎数学から丁寧に解説。〔内容〕深層学習とは/深層学習のための数学入門/ニューラルネットワークの構造を知る/ニューラルネットワークをどう学習させるか/他

編集部から

・初学者でも安心!

必要な数学(ベクトル・行列・微分・確率)はすべて本の中で解説します。

・「どう使うか」がわかる!

具体的な例題を豊富に収録し,応用をイメージしながら読み進めることができます。

・一冊で最前線へ!

いま注目度の高い深層生成モデル,とくに「GAN」(敵対的生成ネットワーク)の仕組みを学べる数少ない一冊です。

○深層学習の理論を初歩から学びたい方へ

大学学部生から大学院生,エンジニアなど実務家の方まで

●正誤情報(第1, 2刷)

p. 45 問3.7の解答……誤「0.2/0.6 = 1/3」→正「0.4/0.6 = 2/3」

p. 65 最終行……誤「0は活躍社員,1は非活躍社員である.」→正「1は活躍社員,0は非活躍社員である.」

目次

1. 深層学習とは

1.1 ニューラルネットワークのブームは繰り返される

1.2 何が深いのか

1.3 学習するとはどういうことか

1.4 深層学習はなぜうまく行くのか

2. 機械学習で使う用語

2.1 機械学習における各種のタスク

2.2 モデルとパラメータ

2.3 過去問だけ解けてもダメ

3. 深層学習のための数学入門

3.1 数を並べたものはベクトル

3.2 ベクトルの演算

3.3 数を縦横に並べたのが行列

3.4 スカラー・ベクトル・行列はすべてテンソル

3.5 微分・勾配・ヤコビ行列

3.6 確率と統計量

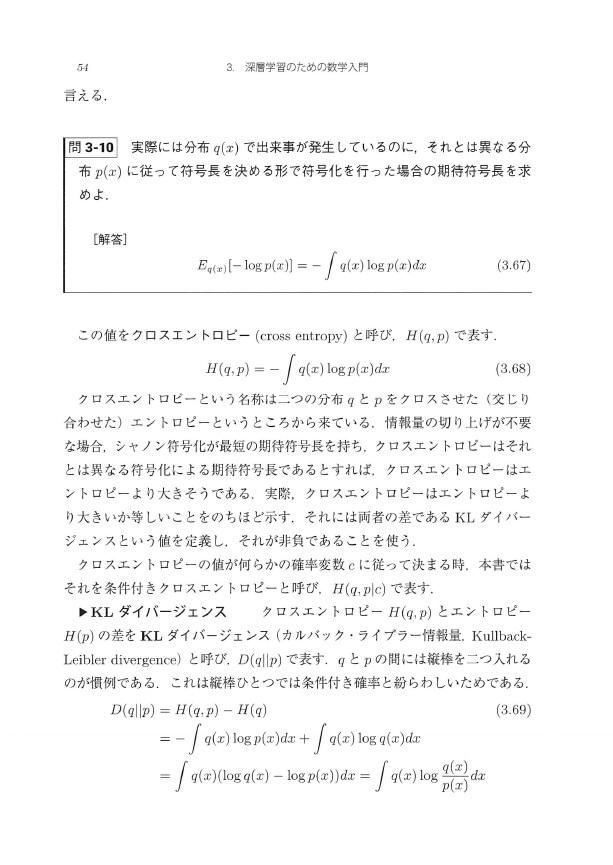

3.7 クロスエントロピーとKLダイバージェンス

4. ニューラルネットワークはどのような構造をしているか

4.1 線形分類器は直線でデータを分類する

4.2 重みはデータに基づいて最適化される

4.3 単純パーセプトロン

4.4 損失関数としてのクロスエントロピー

4.5 経験リスク最小化

4.6 単純パーセプトロンにおけるクロスエントロピー

4.7 ソフトマックス関数

4.8 正規分布と平均二乗誤差

4.9 多層パーセプトロン

4.10 活性化関数

5. ニューラルネットワークをどう学習させるか

5.1 パラメータ空間を動き回るパラメータベクトル

5.2 勾配降下法で山を下る

5.3 確率的勾配降下法

5.4 誤差逆伝播法(バックプロパゲーション)

5.4.1 順伝播でひとまず予測を行う

5.4.2 出力ユニット直前の重み行列の更新規則

5.4.3 中間的な重み行列の更新規則

5.4.4 逆伝播で間違いを伝えていく

5.4.5 デルタの更新規則

5.4.6 勾配消失問題

5.4.7 順伝播と逆伝播の反復

5.5 適応的最適化

5.6 ドロップアウト

5.7 バッチ正規化

6. 畳み込みニューラルネットワーク

6.1 局所特徴

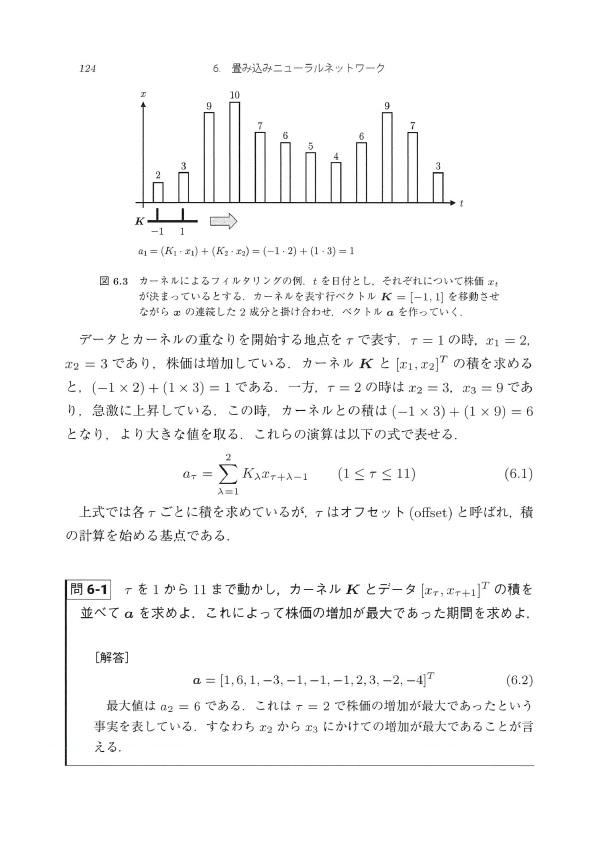

6.2 フィルタリングによって局所特徴を検出する

6.3 畳み込み層

6.3.1 受容野

6.3.2 カーネルの勾配

6.3.3 パディングで縮小を補填

6.3.4 ストライドで大またぎ

6.3.5 チャネルを増やして多数の局所特徴を捉える

6.4 プーリング

6.5 2D-CNN

7. 再帰型ニューラルネットワーク

7.1 系列データ

7.2 再帰型ニューラルネットワークは記憶を持つ

7.3 通時的逆伝播(BPTT)

7.4 LSTMは記憶力をコントロールする

8. 深層生成モデル

8.1 生成モデル

8.2 敵対的生成ネットワーク(GAN)

8.3 転置畳み込み(デコンボリューション)

9. おわりに

章末問題解答

文献案内

索 引

執筆者紹介

手塚太郎(てづか たろう)

1978年 東京都に生まれる

2005年 京都大学大学院情報学研究科博士後期課程修了

現 在 筑波大学 図書館情報メディア系准教授、人工知能科学センター研究員(機械学習分野)

博士(情報学)

情報処理学会、電子情報通信学会、ACM等会員