BOOK SEARCH

確率的機械学習:入門編 II ―非線形モデル―

ケヴィン P. マーフィー(著)/持橋 大地・鈴木 大慈(監訳)

ケヴィン P. マーフィー(著)/持橋 大地・鈴木 大慈(監訳)

定価 8,250 円(本体 7,500 円+税)

B5判/420ページ

刊行日:2025年11月01日

ISBN:978-4-254-12304-3 C3004

ネット書店で購入する amazon e-hon 紀伊國屋書店 丸善ジュンク堂書店 Honya Club Rakutenブックス くまざわ書店

書店の店頭在庫を確認する 紀伊國屋書店

コンテンツダウンロード

- 参考文献Bibliography.pdf

※ 『確率的機械学習:入門編 I・II』参考文献です

内容紹介

Kevin P. Murphy ”Probabilistic Machine Learning: An Introduction“ (MIT Press, 2022) の全訳(2分冊)。基礎の数学からスタートし、機械学習の考え方をじっくり理解することができる決定版テキスト。II巻では深層ニューラルネットワーク、ノンパラメトリックモデルなどを扱う。

編集部から

目次

【I巻略目次】

1 はじめに

I 基礎

2 単変量の確率モデル

3 多変量の確率モデル

4 統計学

5 決定理論

6 情報理論

7 線形代数

8 最適化

II 線形モデル

9 線形判別分析

10 ロジスティック回帰

11 線形回帰

12 一般化線形モデル

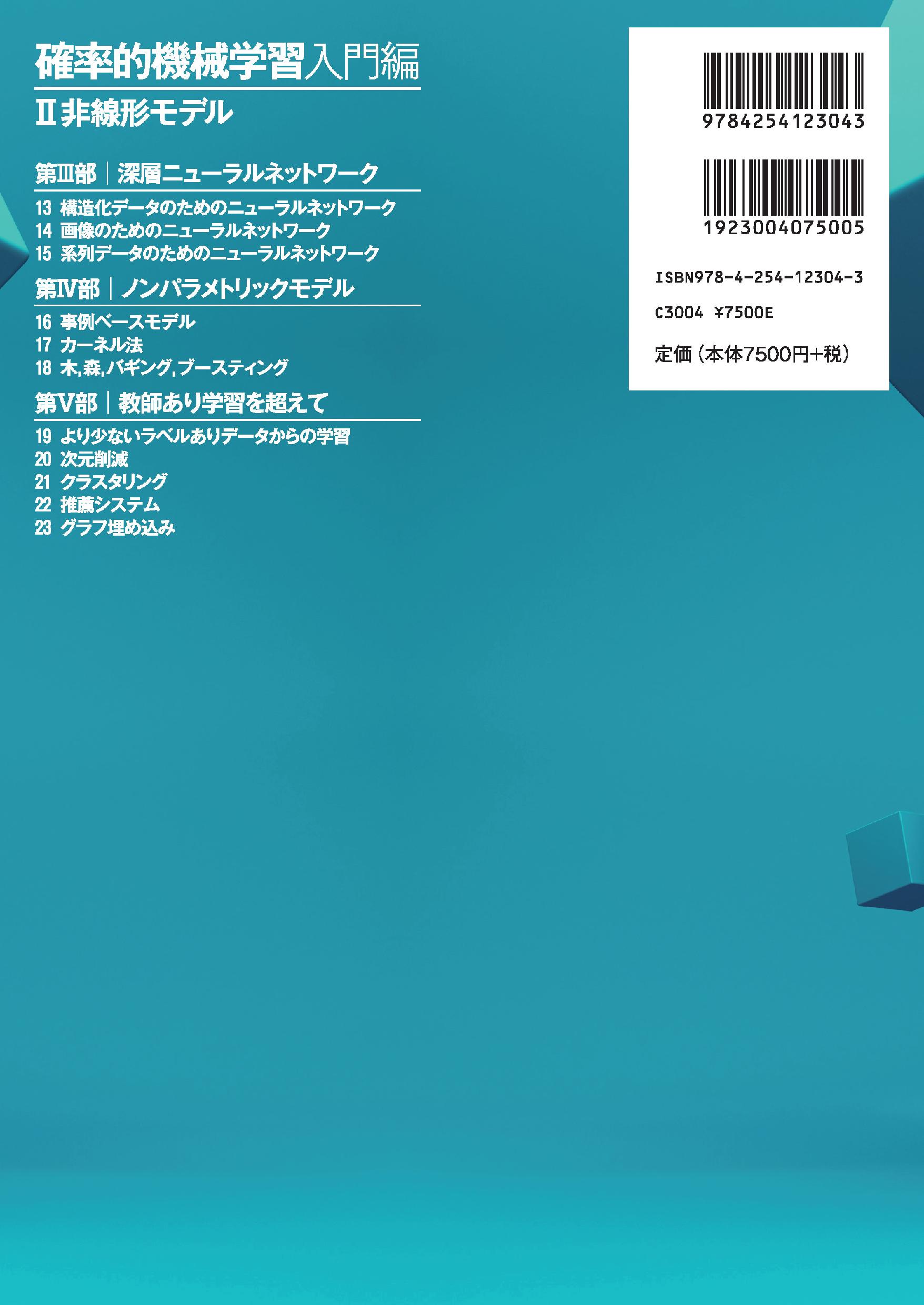

【II巻略目次】

III 深層ニューラルネットワーク

13 構造化データのためのニューラルネットワーク

14 画像のためのニューラルネットワーク

15 系列データのためのニューラルネットワーク

IV ノンパラメトリックモデル

16 事例ベースモデル

17 カーネル法

18 木,森,バギング,ブースティング

V 教師あり学習を超えて

19 より少ないラベルありデータからの学習

20 次元削減

21 クラスタリング

22 推薦システム

23 グラフ埋め込み

【II巻詳細目次】

III 深層ニューラルネットワーク

13 構造化データのためのニューラルネットワーク

13.1 はじめに

13.2 多層パーセプトロン(MLP)

13.2.1 XOR問題

13.2.2 微分可能なMLP

13.2.3 活性化関数

13.2.4 モデルの例

13.2.5 層の深さの重要性

13.2.6 「深層学習革命」

13.2.7 生物学との関連

13.3 誤差逆伝播法

13.3.1 前向き・逆向き微分

13.3.2 MLPに対する逆向き微分

13.3.3 広く利用される層についてのベクトル・ヤコビ行列積(VJP)

13.3.4 計算グラフ

13.4 ニューラルネットワークの訓練

13.4.1 学習率の調整

13.4.2 勾配消失と勾配爆発

13.4.3 飽和しない活性化関数

13.4.4 残差接続

13.4.5 パラメーターの初期化

13.4.6 並列学習

13.5 正則化

13.5.1 早期停止

13.5.2 重み減衰

13.5.3 疎なDNN

13.5.4 ドロップアウト(間引き)法

13.5.5 ベイズ的ニューラルネットワーク

13.5.6 (確率的)勾配降下法の正則化効果

13.5.7 過剰パラメーターモデル

13.6 他の順伝播型ネットワーク

13.6.1 動径基底関数ネットワーク

13.6.2 混合エキスパートモデル

13.7 演習

14 画像のためのニューラルネットワーク

14.1 はじめに

14.2 よく使われる層

14.2.1 畳み込み層

14.2.2 プーリング層

14.2.3 全体の構成

14.2.4 正規化層

14.3 画像認識によく用いられる構造

14.3.1 LeNet

14.3.2 AlexNet

14.3.3 GoogLeNet(インセプション)

14.3.4 ResNet

14.3.5 DenseNet

14.3.6 ニューラル構造探索

14.4 そのほかの畳み込み

14.4.1 拡大畳み込み

14.4.2 転置畳み込み

14.4.3 深さ方向分離畳み込み

14.5 CNNを用いたその他の画像識別タスク

14.5.1 画像タグ付け

14.5.2 物体検出

14.5.3 個体セグメンテーション

14.5.4 意味的セグメンテーション

14.5.5 人物姿勢推定

14.6 CNNの反転による画像生成

14.6.1 学習済み分類モデルから生成モデルへの変換

14.6.2 画像事前分布

14.6.3 CNNが学習した特徴の可視化

14.6.4 Deep Dream

14.6.5 ニューラル画風転写

15 系列データのためのニューラルネットワーク

15.1 はじめに

15.2 再帰型ニューラルネットワーク(RNN)

15.2.1 vec2sec(系列の生成)

15.2.2 seq2vec(系列分類)

15.2.3 seq2seq(系列変換)

15.2.4 教師による強制

15.2.5 時間方向誤差逆伝播

15.2.6 勾配消失と勾配爆発

15.2.7 ゲートの導入と長期記憶の実現

15.2.8 ビーム探索

15.3 1次元畳み込みニューラルネットワーク

15.3.1 1次元CNNによる系列分類

15.3.2 因果的1次元CNN による系列生成

15.4 注意機構

15.4.1 柔らかい辞書検索としての注意機構

15.4.2 ノンパラメトリックな注意機構とカーネル回帰

15.4.3 パラメトリックな注意機構

15.4.4 注意機構を用いた系列変換

15.4.5 注意機構を用いたseq2vec(テキストの分類)

15.4.6 注意機構を用いたsec+sec2vec(テキストのペアの分類)

15.4.7 ソフトな注意機構vs ハードな注意機構

15.5 トランスフォーマー

15.5.1 自己注意機構

15.5.2 多ヘッド注意機構

15.5.3 位置埋め込み

15.5.4 部品をまとめ上げる

15.5.5 トランスフォーマー,CNN,RNN の比較

15.5.6 トランスフォーマーを画像処理に利用する

15.5.7 トランスフォーマーのさらなる変種

15.6 計算効率のよいトランスフォーマー

15.6.1 学習できない局所的な注意パターン

15.6.2 学習できる局所的な注意パターン

15.6.3 記憶装置と再帰構造

15.6.4 低ランク分解とカーネル法

15.7 言語モデルと教師なし表現学習

15.7.1 ELMo

15.7.2 BERT

15.7.3 GPT

15.7.4 T5

15.7.5 議論

IV ノンパラメトリックモデル

16 事例ベースモデル

16.1 K近傍分類

16.1.1 具体例

16.1.2 次元の呪い

16.1.3 高速化とメモリー使用量の削減

16.1.4 オープンセット認識

16.2 距離学習

16.2.1 線形・凸定式化

16.2.2 深層距離学習

16.2.3 分類損失

16.2.4 ランキング損失

16.2.5 ランキング損失最適化の高速化

16.2.6 深層距離学習のためのその他のテクニック

16.3 カーネル密度推定(KDE)

16.3.1 密度カーネル

16.3.2 パルツェン窓密度推定

16.3.3 バンド幅パラメーターの選択

16.3.4 カーネル密度推定からK 近傍分類へ

16.3.5 カーネル回帰

17 カーネル法

17.1 マーサーカーネル

17.1.1 マーサーの定理

17.1.2 代表的なマーサーカーネル

17.2 ガウス過程

17.2.1 ノイズのない観測データ

17.2.2 ノイズのある観測データ

17.2.3 カーネル回帰との比較

17.2.4 重み空間と関数空間

17.2.5 数値的な問題

17.2.6 カーネルの推定

17.2.7 ガウス過程を使った分類

17.2.8 深層学習とのつながり

17.2.9 大規模なデータへのGPの拡張

17.3 サポートベクトルマシン(SVM)

17.3.1 大きなマージンを持つ分類器

17.3.2 双対問題

17.3.3 ソフトマージン分類器

17.3.4 カーネルトリック

17.3.5 SVMの出力を確率に変換する方法

17.3.6 ロジスティック回帰との関係

17.3.7 SVMによる多クラス分類

17.3.8 正則化係数Cの選び方

17.3.9 カーネルリッジ回帰

17.3.10 回帰のためのSVM

17.4 スパースベクトルマシン

17.4.1 関連ベクトルマシン

17.4.2 スパースなカーネル法と密なカーネル法の比較

17.5 演習

18 木,森,バギング,ブースティング

18.1 分類木と回帰木(CART)

18.1.1 モデルの定義

18.1.2 モデルフィッティング

18.1.3 正則化

18.1.4 入力データの特徴量の欠測の取り扱い方

18.1.5 木の利点と欠点

18.2 アンサンブル学習

18.2.1 スタッキング

18.2.2 アンサンブルとベイズモデル平均の違い

18.3 バギング

18.4 ランダムフォレスト

18.5 ブースティング

18.5.1 段階的加法モデル

18.5.2 二乗損失と最小二乗ブースティング

18.5.3 指数損失とアダブースト

18.5.4 ロジットブースト

18.5.5 勾配ブースティング

18.6 木のアンサンブルの解釈

18.6.1 特徴量重要度

18.6.2 部分依存図

V 教師あり学習を超えて

19 より少ないラベルありデータからの学習

19.1 データ拡張

19.1.1 具体例

19.1.2 理論的な正当化

19.2 転移学習

19.2.1 ファインチューニング

19.2.2 アダプター

19.2.3 教師あり事前学習

19.2.4 教師なし事前学習(自己教師あり学習)

19.2.5 ドメイン適応

19.3 半教師あり学習

19.3.1 自己訓練(疑似ラベリング)

19.3.2 エントロピー最小化

19.3.3 共訓練

19.3.4 グラフ上のラベル伝播

19.3.5 一致正則化

19.3.6 深層生成モデル

19.3.7 自己教師あり学習と半教師あり学習の融合

19.4 能動学習

19.4.1 決定理論的アプローチ

19.4.2 情報理論的アプローチ

19.4.3 バッチ能動学習

19.5 メタ学習

19.5.1 モデル非依存メタ学習(MAML)

19.6 少数ショット学習

19.6.1 マッチングネットワーク

19.7 弱教師あり学習

19.8 演習

20 次元削減

20.1 主成分分析(PCA)

20.1.1 具体例

20.1.2 アルゴリズムの導出

20.1.3 計算上の問題

20.1.4 潜在次元数の選び方

20.2 因子分析

20.2.1 生成モデル

20.2.2 確率的主成分分析

20.2.3 因子分析・確率的主成分分析のEMアルゴリズム

20.2.4 パラメーターの識別不可能性

20.2.5 非線形因子分析

20.2.6 混合因子分析

20.2.7 指数型分布族による因子分析

20.2.8 ペアデータのための因子分析モデル

20.3 自己符号化器

20.3.1 ボトルネック自己符号化器

20.3.2 ノイズ除去自己符号化器

20.3.3 縮小自己符号化器

20.3.4 スパース自己符号化器

20.3.5 変分自己符号化器

20.4 多様体学習

20.4.1 多様体とは?

20.4.2 多様体仮説

20.4.3 多様体学習へのアプローチ

20.4.4 多次元尺度構成法(MDS)

20.4.5 Isomap

20.4.6 カーネル主成分分析

20.4.7 最大分散展開(MVU)

20.4.8 局所線形埋め込み(LLE)

20.4.9 ラプラシアン固有写像

20.4.10 t-SNE

20.5 単語埋め込み

20.5.1 潜在意味解析と潜在意味インデックス

20.5.2 Word2vec

20.5.3 GloVe

20.5.4 単語の類推

20.5.5 RAND-WALK モデル

20.5.6 文脈化単語埋め込み

20.6 演習

21 クラスタリング

21.1 はじめに

21.1.1 クラスタリングの結果の評価

21.2 階層的凝集クラスタリング

21.2.1 アルゴリズム

21.2.2 具体例

21.2.3 拡張

21.3 K 平均法クラスタリング

21.3.1 アルゴリズム

21.3.2 具体例

21.3.3 ベクトル量子化

21.3.4 K-means++アルゴリズム

21.3.5 K メドイドクラスタリング

21.3.6 高速化法

21.3.7 クラスター数K の選択

21.4 混合モデルを用いたクラスタリング

21.4.1 混合ガウスモデル

21.4.2 混合ベルヌーイモデル

21.5 スペクトラルクラスタリング

21.5.1 正規化カット

21.5.2 グラフラプラシアンの固有ベクトルとクラスタリング

21.5.3 具体例

21.5.4 他の手法との関係

21.6 両クラスタリング

21.6.1 基本的な両クラスタリング

21.6.2 入れ子になった分割モデル(crosscat)

22 推薦システム

22.1 明示的なフィードバック

22.1.1 データセット

22.1.2 協調フィルタリング

22.1.3 行列分解

22.1.4 自己符号化器

22.2 暗黙的なフィードバック

22.2.1 ベイズ的個別化ランキング

22.2.2 因子分解マシン

22.2.3 ニューラル行列分解

22.3 補助情報の活用

22.4 探索と活用のトレードオフ

23 グラフ埋め込み

23.1 はじめに

23.2 符号化器・復号化器問題としてのグラフ埋め込み

23.3 浅いグラフ埋め込みモデル

23.3.1 教師なし埋め込み

23.3.2 距離に基づく手法:ユークリッド空間上の手法

23.3.3 距離に基づく手法:非ユークリッド空間上の手法

23.3.4 外積に基づく手法:行列分解の手法

23.3.5 外積に基づく手法:スキップグラム法

23.3.6 教師あり埋め込み

23.4 グラフニューラルネットワーク

23.4.1 メッセージ伝達グラフニューラルネットワーク

23.4.2 スペクトルグラフ畳み込み

23.4.3 空間的なグラフ畳み込み

23.4.4 非ユークリッド的なグラフ畳み込み

23.5 深層グラフ埋め込みの学習

23.5.1 教師なし埋め込み

23.5.2 半教師あり埋め込み

23.6 応用

23.6.1 教師なし設定の応用

23.6.2 教師あり設定の応用

A 記 号

参考文献

索 引

執筆者紹介

原著者

ケヴィン・P・マーフィー Kevin P. Murphy

Google

監訳者

持橋大地(もちはしだいち)

統計数理研究所統計基盤数理研究系 教授

鈴木大慈(すずきたいじ)

東京大学大学院情報理工学系研究科 教授

訳者

石黒勝彦/伊藤伸志/梶野洸/黒木祐子/小宮山純平/佐藤竜馬/鈴木大慈/包含/手嶋毅志/幡谷龍一郎/二見太/南賢太郎/持橋大地/横井祥